프로세싱-인-메모리(PIM) 기반 AI 추천시스템

[IT비즈뉴스 최태우 기자] 카이스트(KAIST) 연구진이 세계 최초로 ‘프로세싱-인-메모리(Processing-In-Memory, PIM)’ 기술이 적용된 인공지능(AI) 추천시스템 학습 알고리즘 가속에 최적화된 지능형 반도체시스템 개발에 성공했다.

KAIST는 16일 전기및전자공학부 유민수 교수 연구팀이 PIM 기술 기반의 메모리-중심 AI가속기 시스템을 개발했다고 밝혔다.

AI 기반으로 고안된 추천시스템 알고리즘은 구글, 페이스북, 유튜브, 아마존 글로벌 테크기업이 콘텐츠 추천과 개인 맞춤형 광고를 제공하는 기반이 되는 핵심기술이다.

온라인 광고를 통한 수입은 구글과 페이스북과 같은 실리콘밸리의 빅테크 기업의 주 수익 모델인 만큼 고도화된 추천 AI기술에 대한 수요도 크게 느는 추세다.

페이스북이 공개한 자료에 따르면 페이스북 데이터센터에서 처리되는 AI 연산의 70%가 추천 알고리즘을 처리하는 데에 사용된다. 알고리즘 학습을 위한 컴퓨팅 자원의 50%는 추천 알고리즘을 학습하는 데 쓰인다.

AI 기반 추천시스템 알고리즘은 각각의 사용자 및 추천객체를 임베딩(Embedding)이라 불리는 추상화된 데이터 형태로 학습-저장하면서 학습한 임베딩을 기반으로 개인 맞춤형 추천기능을 제공하는 구조다.

추천 객체, 사용자 수에 따라 학습 및 저장해야할 정보가 증가하는 특성으로 추천 AI의 경우 기존의 음성·이미지 처리를 위한 AI와는 크기나 연산 특성이 다르다. 이로 인해 알고리즘 수행을 위한 다량의 메모리, 높은 대역폭이 필요하며 때론 시스템에서 병목현상이 발생할 수도 있다.

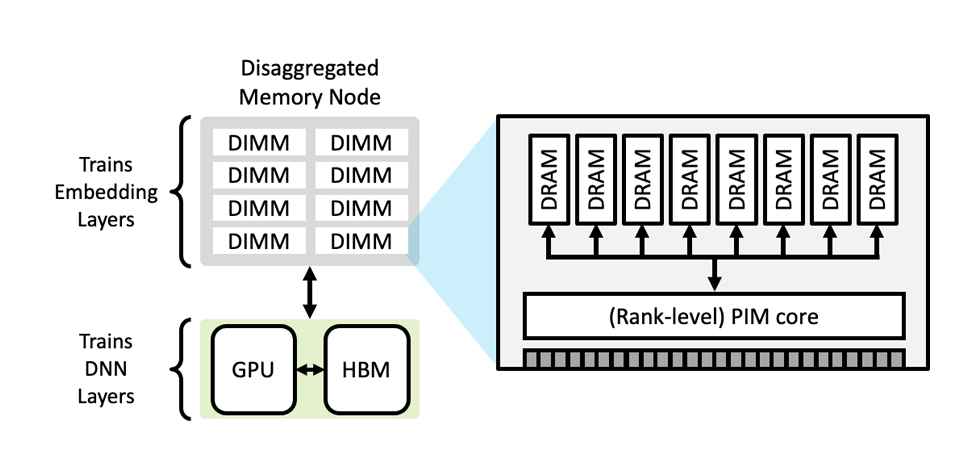

유민수 교수팀은 임베딩의 학습과정에서 수행되는 모든 연산을 단일 연산으로 변환할 수 있는 알고리즘을 개발했다. 이 알고리즘은 기존 방식 대비 메모리 대역폭 사용량을 크게 줄이고 수행되는 연산을 단일화해 효율적인 하드웨어 가속기를 구현했다.

이 알고리즘을 기반으로 개발된 가속기는 하드웨어 복잡도가 감소한 임베딩 가속기를 기존 상용화된 메모리 장치에 추가하는 방식으로 임베딩의 저장-연산을 동시에 효과적으로 수행할 수 있는 구조다.

이를 활용한 가속기 시스템 구축을 통해 대규모 추천 AI 학습 과정을 최대 21배까지 가속할 수 있음을 보였다.

특히 AI 추천시스템 알고리즘의 학습 과정에서 엔비디아 등 그래픽카드(GPU)를 사용한 GPU 가속 시스템 대비 최대 21배까지 빠르다는 게 연구팀의 설명이다.

유민수 교수는 관련 분야에서 그간의 연구성과를 인정받아 올해 아시아에서 유일하게 페이스북 패컬티 리서치 어워드(Facebook Faculty Research Award)를 수상한 바 있다.

삼성미래기술육성재단이 지원하고 KAIST 전기및전자공학부 권영은 박사과정이 제1 저자, 이윤재 석사과정이 제2 저자로 참여한 이번 연구는 ‘IEEE International Symposium on High-Performance Computer Architecture(HPCA)’에서 내년 2월에 발표될 예정이다.

관련기사

- [그것을 알려주마] “AMD-자일링스(Xilinx) 인수합병, 경쟁자는 진짜 인텔(Intel)인가?”

- 슈퍼마이크로, 블루필드2 DPU 탑재 서버 포트폴리오 확장

- 삼성, 미래기술육성사업 하반기 연구과제 31개 선정·발표…396억원 지원

- 퀄컴, AI추론 가속기 ‘클라우드 AI100’ 출하…내년 상반기 양산

- “ARM은 왜? 64비트 R코어 반도체 설계자산(IP)을 발표했나”

- NXP반도체, 머신러닝(ML) 애플리케이션 위한 글로우(Glow) 신경망 컴파일러 공개

- ‘초당 460GB 데이터 처리 가능’…SK하이닉스, 초고속 D램 ‘HBM2E’ 양산

- UNIST·삼성종합기술원, ‘미세공정’ 한계 돌파 가능한 신소재 개발

- 엔비디아, HBM2e 80GB 탑재한 A100 80 GPU 공개

- 삼성 ‘2020 애뉴얼 포럼’ 개최…기초과학·ICT 연구성과 공유