At the center of this Smart City Mobility and Transportation Hub are two intersections made intelligent thanks to Continental sensors and intelligent software integrated into the infrastructure. Ultimately, this technology will have the potential to improve traffic flow, add convenience, reduce pollution and, most importantly, significantly increase the intersection’s safety by communicating hidden dangers to approaching connected vehicles and pedestrians.

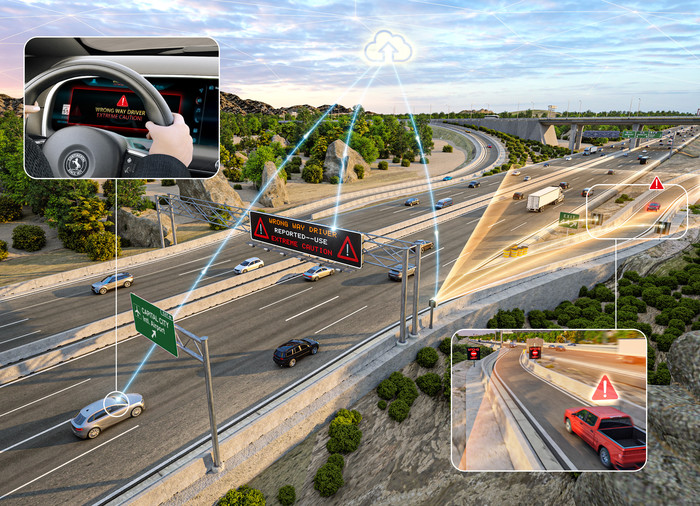

Furthermore, Continental’s Wrong-Way Driver detection system, which warns at-risk drivers in the vicinity of a driver heading the wrong way, has also been installed.

“With about 80 percent of Americans living in urban areas, a steady increase in pedestrian fatalities, and more than 43 percent of crashes taking place at intersections, a focus on improved safety at city intersections has never been more important,” said Jeremy McClain, director of Chassis and Safety Systems and Technology for Continental, North America.

“By bringing together a variety of automotive-grade technologies, systems and expertise, Continental’s Smart City technologies have the potential to greatly improve the lives of everyone who enters the area.”

In its current phase, the Smart City Mobility and Transportation Hub is collecting important non-personally identifiable information, like location and movement patterns, about pedestrians, vehicles and other intersection-related activity to create an environment model needed for infrastructure-to-everything(I2X) communication.

The environment model provides information about traffic participants, traffic infrastructure, static objects and the overall road situation to connected vehicles.

“With Continental’s sensor technology, we want to apply our years of experience in the automotive industry to make intersections more intelligent, and therefore safer and more efficient,” said Laurent Fabre, head of Passive Safety and Sensorics Business Unit at Continental.

For decades Continental has engineered products and systems for vehicles that make roads safer, driving more convenient and road users more connected. Now it is applying that same expertise to equip infrastructure with the ability to sense its surroundings and ultimately communicate what it sees to road users.

The Smart City Mobility and Transportation Hub infrastructure is equipped with Continental’s state-of-the-art short- and long-range radars.

These radar sensors have been deployed on a number of vehicle platforms over the years, and enable functions like adaptive cruise control, blind spot detection, forward collision warning, lane change assist and more. Continental now looks to apply the economies of scale together with its software functions knowhow from automotive to the infrastructure.

In addition to the Continental radar sensors, the Auburn Hills Smart City Mobility and Transportation Hub also has a roadside unit and electronic control unit to process data and run the environment model and functions.

This combination can offer a number of benefits, like counting the number of vehicles entering and exiting a specific zone to communicate the number of available parking spaces to interested vehicles. By connecting to a traffic light controller, traffic flow can be better optimized, reducing not only congestion, but also emissions from idling vehicles.

The solution makes it possible to warn an approaching vehicle about occluded hazards such as pedestrians. With additional analysis and artificial intelligence, intention prediction of pedestrians becomes possible, helping to alert drivers to pedestrians planning to cross even when the vehicle has the right of way.

“Auburn Hills is excited to partner with Continental to provide a real-world test location for Smart City Technology that will make the future of transportation safer not only for motorists, but cyclists, pedestrians, and other users within the confluence of the intersection,” said Auburn Hills Mayor Kevin McDaniel.

관련기사

- [오토모티브월드 나고야] 현장 이모저모…자율주행·경량화소재기업, MaaS/TaaS 스타트업 부스 ‘인기’

- ATaaS 스타트업 코드42, 300억원 규모 투자유치 성공

- EV 설계·제조 스타트업 ‘WM모터’, 안정성·보안설계에 블랙베리QNX 솔루션 도입

- Cintra and Assembly Intelligence Partner to Focus on Smart Transportation Infrastructure

- Kinara and Arcturus Partnership to Provide High Performance AI Solutions

- Continental Exclusive 4D Radar Sensor Sponsor for the Indy Autonomous Challenge

- Continental Develops CPD Technology Aimed at Reducing Child Fatalities

taewoo.choi

taewoo@itbiznews.com